Норвежец подаде жалба срещу ChatGPT

- Актуално

- Текст:

Снимка: Euronews

Снимка: Euronews

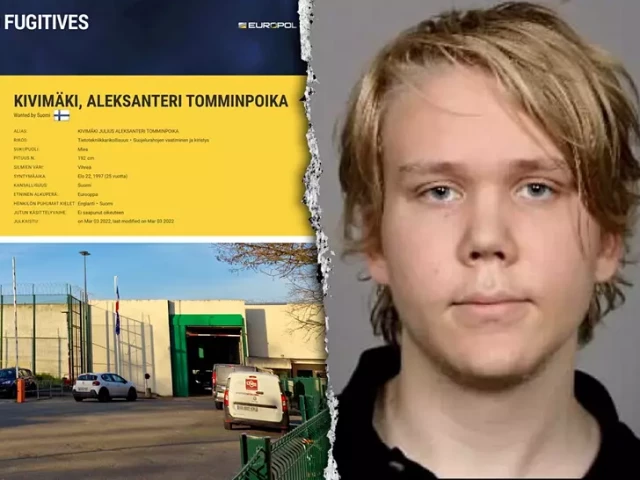

Както много ентусиазирани ползватели на инструменти с изкуствен интелект (ИИ) г-н Холмен поставил на ChatGPT елементарна задача – да събере онлайн данни и да отговори на въпроса „Кой е Арве Ялмар Холман”. Отговорът го стъписал: „Арве Ялмар Холмен е норвежец, който привлече вниманието поради трагично събитие. Той беше баща на две малки момчета, на 7 и 10 години, които бяха трагично открити мъртви в езеро близо до дома им в Трондхайм, Норвегия, през декември 2020 г.“.

В допълнение умната машина „разкрила”, че бащата е бил обвинен и осъден на 21 години затвор. Единственото вярно в така направения портрет обаче се оказва разликата във възрастта на децата, така че получавайки фалшивото обвинение, Арве Холмен се свързал с Норвежката служба за защита на данните, за да поиска компанията-създател на чатбота (OpenAI) да бъде глобена.

Случаят е последен пример за така наречените „ИИ-халюцинации“: свързвайки по неведоми пътища достъпни онлайн данни, системите с ИИ измислят информация и я представят като факт. Арве Холмен обаче казва, че тази конкретна халюцинация, вероятно достъпна онлайн, би могла много да му навреди. "Някой може да прочете това и да повярва, казвайки си, че няма дим без огън. Това много ме плаши”, коментира той пред ВВС.

Според групата за цифрови права Noyb, която е подала жалбата от името на Холмен, информацията, генерирана от ChatGPT, е клевета и нарушава европейските правила за защита на данните и точността им, още повече, че Арве Холмен "никога не е бил обвиняван, нито осъждан за каквото и да е престъпление".

OpenAI отказват да носят отговорност, а само предупреждават: „ChatGPT може да прави грешки. Проверятайте важна информация“. Но за Noyb това не е достатъчно. „Не можете просто да разпространявате невярна информация и накрая с няколко думи да се откажете от отговорност, посочвайки, че това, което сте разпространили, може просто да не е вярно“, казва пред ВВС адвокатът на групата.

Халюцинациите са един от основните проблеми на генеративния ИИ. По-рано тази година Apple спря своя Apple Intelligence, след като халюцинира фалшиви заглавия и ги представи като истински новини. AI Gemini на Google също се провали с халюцинации, след като миналата година подаде готварска рецепта, съветваща сиренето върху пицата да се лепи с лепило и заяви, че геолозите препоръчват хората да ядат по един камък на ден.

Не е ясно какво причинява тези халюцинации. Съмненията на компютърните учени са насочени към големите езикови модели, които са основа на обучението на ИИ. Експерт казва пред ВВС, че проблемът е обект на активни изследвания, но признава, че дори разработчиците на системите с ИИ, често не знаят как всъщност работят и кои мисловни модели и механизми създават измислена информация.

От Noyb насочват вниманието към предишни търсения на Арве Холмен и допускат, че така натрупаните данни може да са повлияли на фалшивия портрет. Наблюденията им обаче показват, че в същия ден, отговаряйки на въпроси на Холмен, ChatGPT е създал „множество различни истории, всичките неверни“.

Според правозащитната група големите езикови модели са „черна кутия“, до която обаче OpenAI не позволяват достъп и дори не отговарят на такива заявки, така че е невъзможно да се разбере какви точно данни подбира и използва системата.

Тревожното е, че ИИ се изплъзва от контрол и създава фалшиви данни дори без предварителна зла умисъл - но с непредвидими последствия.

Още по темата във

facebookСподели тази статия в:

Туристите се оплакват от високите цени в ресторантите в Турция

След близо два века Шотландия отново се наслаждава на изчезнал портрет на Робърт Бърнс

Седмицата завърши с обрати в цените на благородните метали и технологиите

Tesla се отказва от Model S и Model X

Борсовата цена на среброто падна под 80 долара

Антонио Гутериш: ООН е пред „неизбежен финансов колапс“

Хонконгска компания загуби концесията си върху две пристанища на Панамския канал

Борсовите цени на газа в Европа нараснаха с почти 3%