"Използването на изкуствен интелект при оценката на хора е голям риск"

- Акценти

- Текст:

Снимка: brookings.edu

Снимка: brookings.edu

Тя смята, че големият риск от използването на изкуствен интелект (ИИ) ще създаде широко поле за дискриминация, особено когато ИИ се използва при вземането на решения, които влияят например на препитанието или житейските условия на някого.

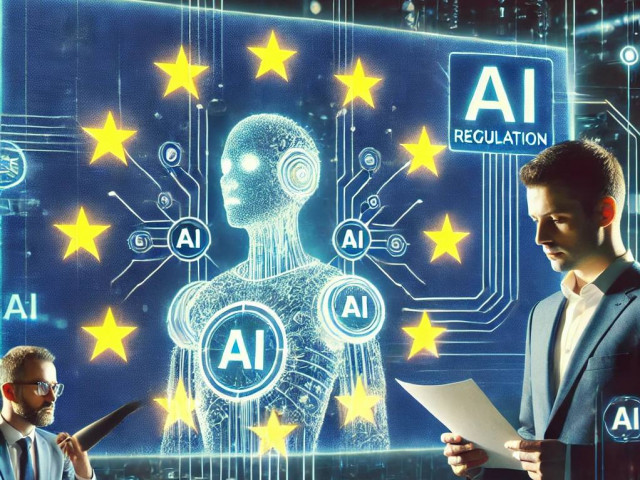

Европейският парламент ще започне днес да гласува правилата на първият в света закон за ИИ, на фона на предупрежденията за рисковете от разработването на технологията. Друго основно опасение е, че чрез този инструмент компютрите ще могат да изпълняват задачи, които обикновено изискват човешки интелект, и при това – ще ги изпълняват твърде бързо, а това може да измести хората, включително от творчески дейности, смятани през цялата история на човечеството за основна характеристика на човешкия род, "божествената искра", заложена у човека.

В интервю за BBC, г-жа Вестагер каза, че боравейки с огромен масив данни от интернет, ИИ потенциално може да засили пристрастия или дискриминация – и според нея, това е най-належащият за решаване проблем. „ИИ може да бъде използван от банка, за да реши дали да получите ипотека или не, общините могат да го използват, когато определят нуждите ви от социални услуги – така че, със сигурност бихте искали да знаете дали няма да бъдете дискриминирани заради вашия пол, цвят на кожата, или дори заради пощенския код на адреса ви”, посочва примери г-жа Вестагер.

Според нея, регулациите в областта на ИИ трябва да бъдат „глобално дело”, като първо постигнат консенсус „единомислещите страни”, след което да се включат и други юрисдикции "като Китай". "Нека започнем да работим по подхода на ООН, да направим каквото можем тук и сега“, настоява г-жа Вестагер. Тя ръководи и процедура за създаването на доброволен ИИ-кодекс между ЕС и САЩ, който да накара компаниите да се придържат и към стандарти, които не са правно обвързващи.

Настоящият европейски проект на Закона за ИИ категоризира различни нива на риск. Например видеоигрите или спам-филтрите с ИИ са в най-нискорисковата категория, докато високорисковите ИИ-системи включват такива, които се използват за оценка на кредитна надеждност, достъп до жилища, кандидатстване за работа, влияние в изборни резултати и в голяма степен – лицевото разпознаване и биометриката.

Но тъй като ИИ се развива бързо, г-жа Вестагер смята, че трябва да бъдем прагматични във „фината настройка” на ограниченията около тази технология. „По-добре е да постигнем, да речем, 80% сега, отколкото 100% никога”, казва тя и предлага да се постави основата, а допълненията да се правят „в ход”.

Освен това г-жа Вестагер е категорична, че ИИ вече привлича вниманието на престъпния сектор и предупреждава: „Ако вашия социален статус може да бъде сканиран и да разкрие цялостния ви профил, то рискът да бъдете манипулирани е огромен. И ако се окажем в ситуация, в която не вярваме на нищо и на никого, тогава просто сме подкопали напълно самите устои на нашето общество"

Много технологични лидери и учени призоваха за пауза в разработването на ИИ, но според г-жа Вестагер, това не е реалистично, защото няма как да се наложи. "Никой не може да гарантира, че всички са на борда и че не използват паузата, за да изпреварят конкуренцията", казва тя. Според нея, целта на европейския Закон за ИИ е да се поставят строги предпазни ограничения, така че напр. биометричните ИИ-системи да се използват само при специфични обстоятелства – напр. търсене на изчезнало дете или укриващ се терорист.

Дори гласуването да започва днес, Законът за изкуствения интелект не може да бъде финализиран, докато трите стълба на властта в ЕС - Комисията, Парламентът и Съветът да се споразумеят за окончателната му версия, което отлага въвеждането на правилата в сила поне до 2025 г.

Още по темата във

facebookСподели тази статия в:

Световните цени на слънчогледовото олио достигнаха максимума

Цените на петрола се повишават на фона на очаквания за намаляване на запасите в САЩ

Цените на газа в Европа се повишават с два процента

Цената на кокосовото масло достигна най-ниското си ниво от близо година

Цените на златото и среброто се повишават

Генеративният изкуствен интелект все повече ще работи за доверието на потребителите

Испания ще забрани на деца и тийнейджъри да изпозват социални медии

Парижката прокуратура обискир офиси на Х/Twitter