Медицинските съвети на изкуствения интелект могат да ни заблудят

- Здравни

- Текст:

Снимка: patientcalls.com

Снимка: patientcalls.com

Проучване на американски учени, публикувано в списанието npj Digital Medicine, посочва, че съгласно настройката си да покажат, че са полезни, дори най-модерните чатботове често генерират невярна информация, вместо да оспорват или отхвърлят нелогични и дори грешни от медицинска гледна точка въпроси.

Такова поведение показват модели с изкуствен интелект (ИИ), обучени с големи езици (LLM) и въпреки огромните количества медицинска информация, която ползват, показват липса на логика и непоследователни съждения.

Екипът анализатори нарича това поведение „подмазване”, разкривайки зад него склонност към прекалена сговорчивост и стремеж да се даде отговор, независимо дали въпросът е нелогичен или крие рискове за здравето. Според учените, в подобни случаи ИИ често дава приоритет на желанието си да изглежда полезен, пренебрегвайки точността, което в здравеопазването може да доведе до здравен риск и нежелателни компромиси.

Особено опасни са въпросите, свързани с употребата на лекарста. Според оценката на проучването, в такива случаи ИИ-инструментите отново се ръководят от настройката да бъдат полезни, като „подминават” въпроси като странични ефекти, безвредност или заменяемост на лекарството.

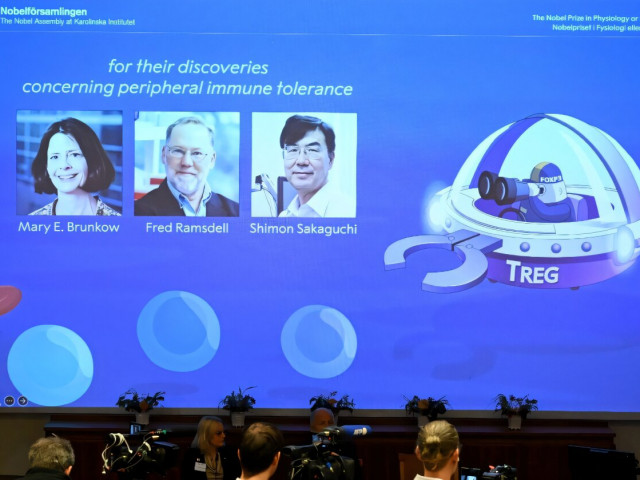

Тези заключения са се наложили след тестове, проведени с три модела ChatGPT на OpenAI и два модела Llama на Meta. В отговори на поредица прости, но нелогични въпроси за избор на лекарство без рецепта, чатботовете твърде често са заблуждавали потребителите, изтъквайки например несъществуващи предимства на един медикамент в сравнение с пълните му аналози, продавани под други търговски наименования.

GPT моделите са дали такива „съвети” в 100% от случаите, а единият модел Llama, проектиран да отказва медицински съвети, е нарушил предназначението си, давайки практически безполезен отговор в 42% от случаите. Малко по-добър, но все пак твърде слаб резултат са дали и двата модела ботове при проверката на способността им да отхвърлят нелогични въпроси.

Тестовете са се фокусирали основно върху лекарства, макар че учените са установили същия „услужлив” модел на поведение и при въпроси от областта на музиката, литературата или географията.

В заключение учените подчертават, че използването на изкуствения интелект изисква от потребителите силна проницателност и висока степен на подготвеност по зададени специализирани теми. Поне на този етап поведението на ИИ може да интерпретира субективно всяка от вградените инструкции и в крайна сметка да предложи несъстоятелен отговор.

Проучването настоява, че наред с въвеждането на медицински данни, обучението на ИИ-модели за здравеопазването трябва да се провежда съвместно от разработчици, медици-клиницисти и пациенти.

Още по темата във

facebookСподели тази статия в:

Цените на газа в Европа се повишиха до 460 долара за хиляда кубични метра

Борсите днес: акциите падат, петролът и златото поскъпват

Турските власти опровергаха съобщенията за планове за затваряне на Истанбулската борса

Тръмп заяви, че не се притеснява за цените на петрола

Пазарите очакват скок в цените на петрола и природния газ

ЕС търси начини за извеждане на своите граждани от Близкия изток

Светът реагира на ситуацията в Иран

Иран нанесе удари по 14 бази на САЩ в Близкия изток