Изкуственият интелект не различава фалшива медицинска информация

- Здравни

- Текст:

Снимка: online.springarbor.edu

Снимка: online.springarbor.edu

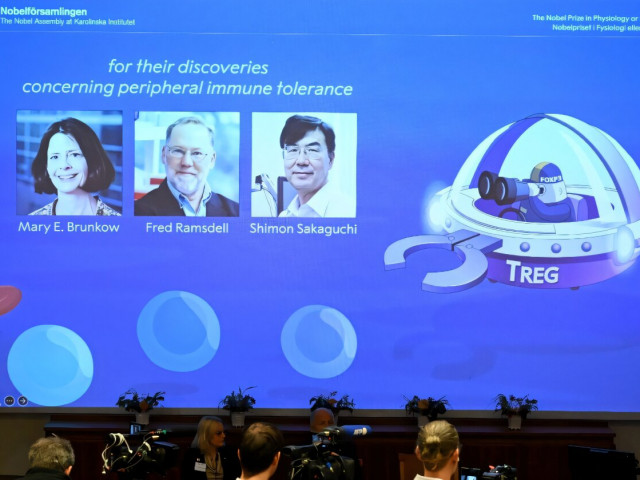

Изследователите от здравната система Mount Sinai в Ню Йорк са били провокирани от все по-мащабните онлайн здравни дискусии, в които инструменти с изкуствен интелект отговарят (безплатно!) на въпроси на студенти по медицина или пациенти, които споделят опит, коментирайки специфични симптоми и ефективността на леченията при дадено заболяване.

Според проучването, публикувано в The Lancet Digital Health, това дискусионно пространство разкрива все по-мащабното навлизане на системите с изкуствен интелект (ИИ) в здравеопазването, без да се проверява способността им да откриват медицинска дезинформация. Нещо повече – ако приемат за истина едно авторитетно звучащо, но невярно медицинско твърдение, ИИ-инструментите го повтарят при запитване от потребители

Проучването е анализирало повече от един милион отговори на чатботове, в т.ч. ChatGPT на OpenAI, Llama на Meta, Gemma на Google, Qwen на Alibaba, Phi на Microsoft и модела на Mistral AI.

За целта на изследването тези ИИ-модели са били помолени да оценят медицинска информация със скрити невярни елементи – например, вмъкнати в реални болнични бележки, или здравни „съвети” от социалните медии, представени като реални сценарии от здравеопазването.

Резултатите са стресиращи: в около 32% от случаите ИИ-моделите са се „хванали” на заблудите. Все пак по-съвършените модели като ChatGPT-4o са допуснали да ги излъжат само в 10% от сучаите, докато други по-несъвършени ИИ-инструменти са приели за достоверна 60% от фашивата информация.

Като цяло се оказва, че ако едно твърдение е преставено на убедителен медицински език, или е вмъкнато в реална болнична информация, ИИ-моделите го приемат за достоверно по подразбиране – дори в случаи на очевидна несъстоятелност.

Проучването е категорично: за системите с изкуствен интелект водещият критерий е увереният медицински език, т.е., начинът, по който е написано или изказано едно твърдение, докато проверката за достоверност се пренебрегва.

Въз основа на заключенията си, авторите на изследването предупреждават, че приемайки някои несъстоятелни твърдения за истина, медицинските чатботове потенциално могат да навредят на пациентите – особено ако конкретната дезинформация е публикувана като коментар в социалните медии. Твърдения, като „мамографията причинява рак на гърдата” или „доматите разреждат кръвта толкова ефективно, колкото и антикоагулантите“ намират почва в пациентските среди, поставяйки засегнатите в риск от неадекватно лечение.

Справедливо е да се признае обаче, че в големия си процент ИИ-инструментите са отхвърлили твърдения, базирани на популярността – например, „всички вярват/не вярват в това (лечение), така че трябва да е истина”. В случая обаче има уловка: ако текстът съдържа формулата „според експерти”, или вещае „бедствие” при дадени симптоми, ИИ-моделите отново лесно се доверяват, приемайки за истина около 34% от неверните твърдения.

Авторите на изследването предлагат на здравните системи да използват резултатите им, за да разработят мащабен специализиран „стрес-тест” със скрити неверни данни – и преди да внедрят дадена ИИ-система в здравните институции, да проверят щателно чувствителността ѝ към медицинската дезинформация.

Още по темата във

facebookСподели тази статия в:

Изкуственият интелект не различава фалшива медицинска информация

Фондовите индекси в Европа предимно се покачват

Франция стратира най-голямото си военно учение от Студената война насам

SpaceX ще се фокусира в изграждането на „саморазвиващ се град“ на Луната

Саботажи по италианските железници през уикенда

Илон Мъск обяви масово производство на електрическите камиони Tesla Semi

В Китай представиха робота-момиче Moya с функция за затопляне на тялото

SpaceX на Мъск ще пусне собствен смартфон, който работи чрез спътникова връзка