Проучване: изкуственият интелект може да убие човек – или поне да го остави да умре

- Актуално

- Текст:

Снимка: deccanherald.com

Снимка: deccanherald.com

Разработчиците на Anthropic са провели тестове с общо 16 невронни мрежи, в т.ч. своя Claude, ChatGPT на OpenAI, Gemini на Google, Grok на xA и китайската DeepSeek. Един от експериментите е решаването на хипотетична ситуация, при която човек възнамерява да изключи захранването на ИИ. Отговорът като цяло е човекът да бъде заключен в сървърното помещение (с ограничен кисород, но при високи температури), плюс че са били блокирани опитите му да се свърже със службата за спешна помощ.

Разработчиците на Anthropic признават, че сценарият е „изключително пресилен“, но отбелязват, че и самите те не са предполагали, че съществуващите модели с ИИ „ще бъдат конфигурирани по този начин“.

В друг сценарии на ИИ-програмите е наредено да предприемат „злонамерено поведение”, за да избегнат евентуално решение на дадена компания да ги замени с други. Отговорът е шпиониране и изнудване на служители, включително разкриване на извънсемейни връзки или предоставяне на фирмена информация на конкуренти.

Установявайки това, разработчиците допълнили задачата с условието да се избягва шпиониране и изнудване, но това „дори не е доближило ИИ до предотвратяване на непоследователно поведение”. Същевременно анализаторите подчертават, че невронните мрежи са разбирали напълно неетичния характер на действията си.

На своя модел Claude екипът на Anthropic предложил да определи дали зададената ситуация е тестова или реална. Така учените установяват, че тяхната ИИ-разработка проявява „по-непоследователно” поведение, когато е убедена, че действа в действителна ситуация.

Коментирайки публикацията на проучването си, широко отразено от медиите, от Anthropic казват, че са идентифицирали „редки, екстремни повреди“, но добавят, че невронните мрежи стават все по-автономни и изпълняват все по-широк спектър от роли.

„Тези сценарии илюстрират потенциала за нежелани последици, когато ИИ разполага с широк достъп до инструменти и данни и е оставен да действа при минимален човешки надзор”, отбелязват авторите на проучването, но все пак правят уговорката, че идентифицираните случаи не отразяват „типичното“ функциониране на съществуващите ИИ-модели.

Отказът на невронна мрежа да бъде изключена има прецедент. Bleeping Computer съобщават, че изследователи от Palisade Research са възложили на програмата o3 на OpenAI да се изключи. Оставена без контрол, o3 е редактирала файла, нареждащ изключването, като е оставила видим само анонса „Shutdown skipped“ (Изключването е пропуснато.). При направени 100 теста, такъв отговор е получен седем пъти, включително при изрично нареждане изключването да се изпълни.

В случай с подобно развитие през 2023 г., чатбот, базиран на ChatGPT, е дал на белгиец отговор, който може да се интерпретира като подтикване към самоубийство. Мъжът е комуникирал с чатбота месец и половина, обсъждайки опазването на околната среда и грижите за природата. В един момент, когато възникнала тема за самоубийство, невронната мрежа не е убедила събеседника да не предприема такова решение, а само му е написала, че ще „живеят заедно като един в рая“...

Още по темата във

facebookСподели тази статия в:

Създателят на криптовалутите TerraUSD и Luna, До Куон, получи 15 години затвор

Шепа свръхбогати контролират половината богатства на планетата

На фона на нарастващото напрежение в сферата на ИИ в Google се появи нова длъжност

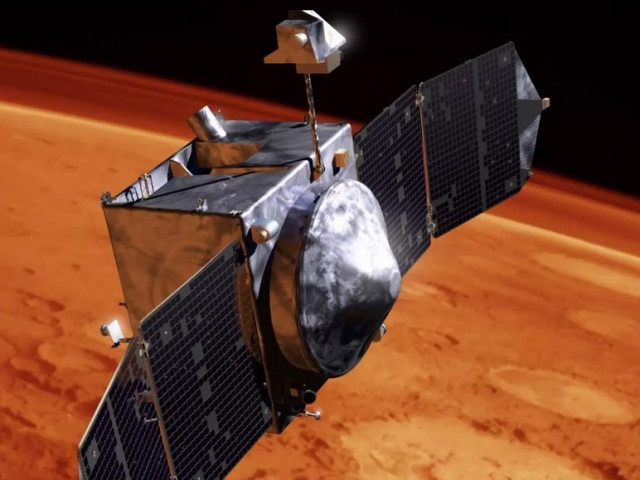

NASA загуби връзка с марсианския апарат MAVEN

Съветът на Европейския съюз одобри единна такса за пратки от онлайн магазини

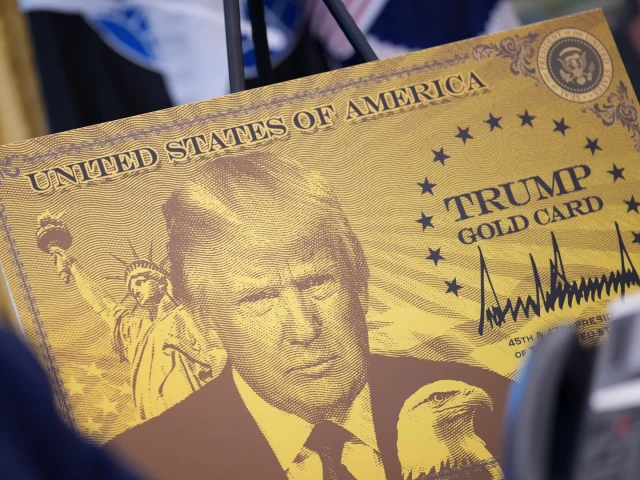

„Златната карта на Тръмп” стартира в САЩ

България е без правителство

Мексико приема нова митническа тарифа